Содержание

- Индексация сайта поисковыми роботами — что это?

- Как проверить индексацию сайта?

- Проверка через Google Search Console

- Проверка с помощью поисковых операторов

- Проверка через Screaming Frog SEO Spider

- Проверка через Site Audit в профессиональных SEO-сервисах

- Проверка соответствия sitemap.xml и robots.txt

- Почему Google не индексирует сайт: причины и решение

- FAQ

Индексация сайта поисковыми роботами — что это?

Индексация — это технический процесс, во время которого поисковые системы с помощью специализированных программных алгоритмов — поисковые роботы или краулеры (web crawlers, spiders, bots) — осуществляют анализ, обработку и структурированное хранение данных о веб-страницах в собственной базе — индексе.

Целью индексации является обеспечение возможности быстрого и релевантного поиска информации. Во время этого процесса поисковая система считывает содержание страницы, определяет ее тематику, ключевые слова, ссылочную структуру и другие сигналы, влияющие на ранжирование.

Индекс поисковой системы — это упорядоченная база данных, в которой хранятся метаданные и контент веб-страниц, обнаруженных в процессе сканирования. Именно благодаря индексации поисковые системы могут оперативно находить, оценивать и показывать пользователям наиболее релевантные результаты по их запросам.

Как проверить индексацию сайта? Основные способы

Проверка индексации сайта — это обязательный этап любого SEO-аудита. Она позволяет определить, какие страницы попали в индекс поисковых систем, а какие остаются вне зоны видимости. Неправильная индексация или ее отсутствие может означать потерю органического трафика, проблемы с краулинговым бюджетом или технические ошибки в структуре сайта.

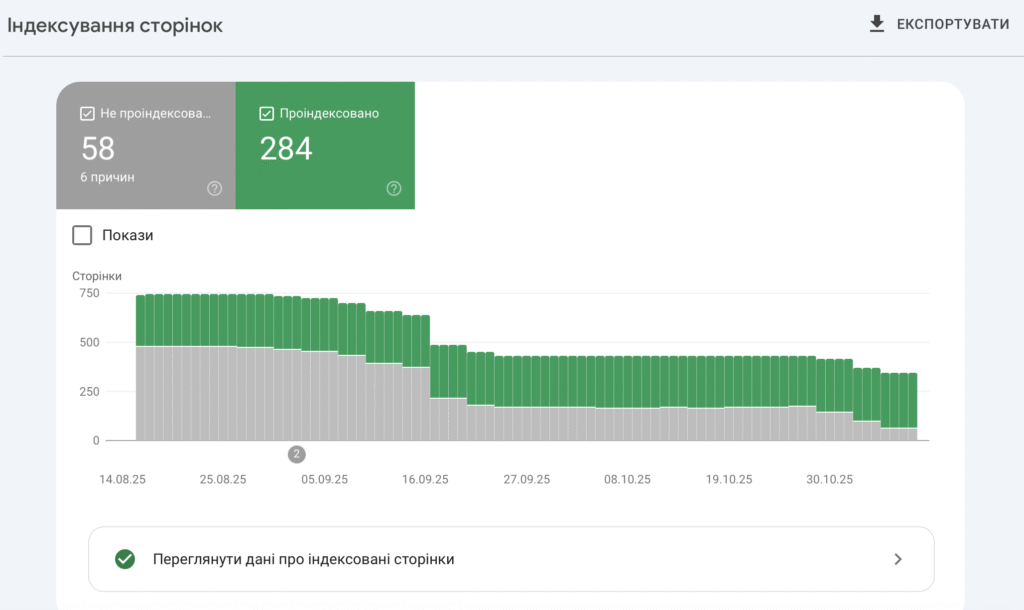

1. Проверка через Google Search Console

Google Search Console (GSC) — основной источник достоверных данных о состоянии индексации. Это официальный инструмент Google, который позволяет отслеживать статус индексации, диагностировать ошибки и инициировать ручное добавление страниц в индекс.

Пошаговая инструкция:

- Перейдите в Google Search Console и добавьте сайт, если он еще не подключен.

- В левом меню откройте раздел «Индексирование → Страницы» (Indexing → Pages).

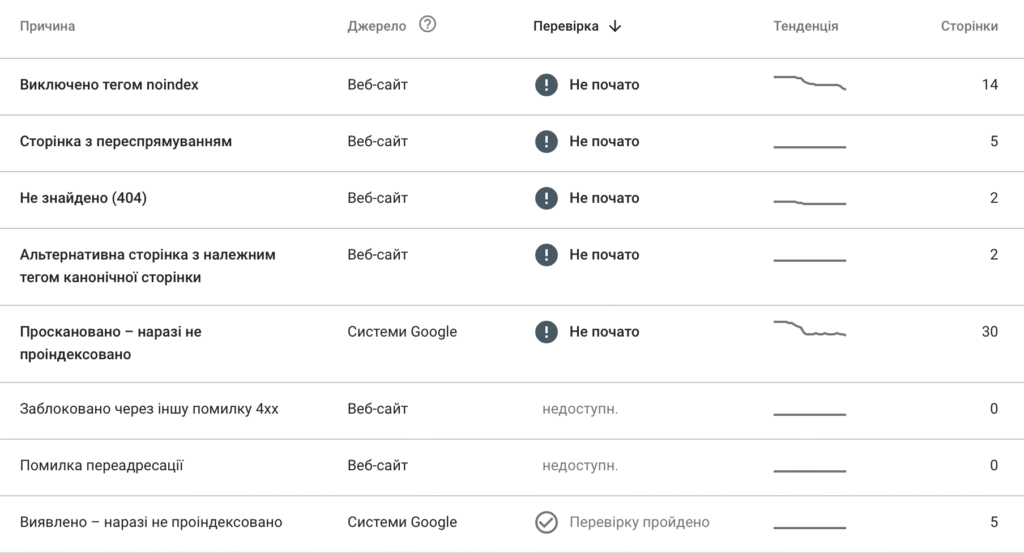

- В отчете вы увидите следующие категории:

- Проиндексировано — страницы в индексе Google.

- Просканировано — пока не проиндексировано, это означает, что Google просканировал страницу, но решил не индексировать ее.

- Исключено тегом noindex — означает, что эти страницы веб-сайта исключены из поисковой индексации (то есть не попадут в результаты поиска).

- Не найдено (404) — поисковые роботы Google пытаются просканировать страницу, которая не существует, потому что она была удалена или ее URL-адрес был изменен.

- Страница с перенаправлением — означает, что Googlebot нашел страницу, которая перенаправляет посетителей на другой URL-адрес, и поэтому не проиндексировал ее.

- Нажмите на любую категорию, чтобы увидеть детали: URL, дату последнего обхода, тип проблемы.

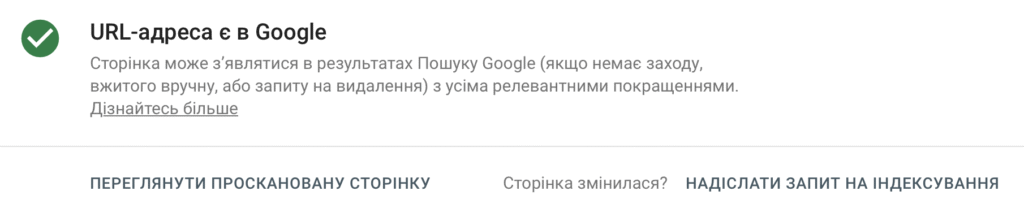

- Для проверки отдельных страниц используйте инструмент «Проверка URL-адреса» (URL Inspection Tool):

- Введите адрес страницы.

- Система покажет статус: «URL в Google», «Обнаружено, но не проиндексировано», «Не проиндексировано» или «Заблокировано robots.txt».

- При необходимости нажмите «Запросить индексацию» (Request Indexing).

Преимущества:

- Данные напрямую из индекса Google.

- Возможность анализа причин неиндексации.

- Поддержка ручного запроса индексации.

Недостатки:

- Не поддерживает массовую проверку большого количества URL.

- Данные обновляются с определенной задержкой (1–3 дня).

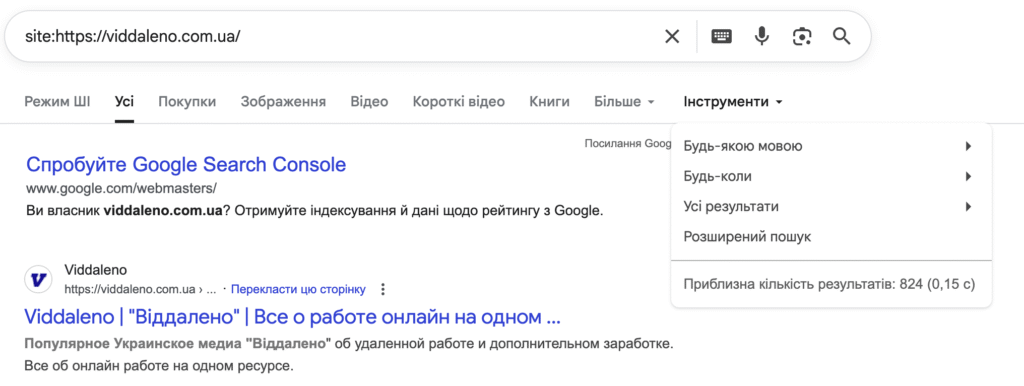

2. Проверка с помощью поисковых операторов

Поисковые операторы — это быстрый способ проверить, есть ли страницы сайта в индексе Google без использования инструментов типа Search Console. Чаще всего SEO-специалисты используют несколько базовых команд:

site:— показывает все страницы домена, присутствующие в индексе.site:example.comЕсли результаты появляются — страницы индексируются. Если нет — они отсутствуют в индексе или заблокированы.cache:— показывает кэшированную копию страницы и дату последнего сканирования.cache:example.com/pageОтсутствие кэша может свидетельствовать об отсутствии страницы в индексе.info:— предоставляет краткую информацию о странице, если она проиндексирована.info:example.com/pageinurl:— ищет страницы, которые содержат определенное слово в адресе. Используется для проверки индексации отдельных категорий или фильтров.site:example.com inurl:blog

Поисковые операторы позволяют быстро проверить видимость сайта в индексе, но не дают точного количества страниц или диагностики причин неиндексации. Для более детального анализа результаты стоит проверять в Google Search Console.

3. Проверка через Screaming Frog SEO Spider

Screaming Frog SEO Spider — профессиональный инструмент для глубокого технического анализа сайта. Его возможности позволяют определить, доступны ли страницы для индексации, а также выявить технические барьеры.

Пошаговая инструкция:

- Загрузите программу с официального сайта Screaming Frog.

- Введите URL сайта в поле «Enter URL to spider».

- После завершения сканирования откройте вкладку Indexability:

- «Indexable» — страницы, открытые для индексации.

- «Non-indexable» — страницы с ограничениями (noindex, canonical, redirect, robots.txt).

- Во вкладке Directives проверьте наличие директив

noindexилиnofollow. - Во вкладке Status Codes проверьте, нет ли страниц с кодами 404, 301, 302.

- В Canonical проверьте, не дублируются ли страницы.

Читать: Noindex и Nofollow: как закрыть внешние ссылки?

Преимущества:

- Детальный технический анализ всех страниц.

- Выявление проблем, препятствующих индексации.

- Возможность экспорта результатов в формат CSV для аналитики.

Недостатки:

- Не показывает фактический статус в Google (требуется интеграция с GSC).

4. Проверка через Site Audit в профессиональных SEO-сервисах

Для средних и крупных проектов целесообразно использовать аналитические платформы, позволяющие массово проверять статус индексации и другие SEO-сигналы. Самые эффективные сервисы:

- Ahrefs Site Audit — анализирует проиндексированные страницы, проверяет проблемы краулинга, дубликатов, canonical.

- SEMrush Site Audit — показывает процент страниц в индексе, наличие технических ошибок, проблемы с meta-тегами.

- Serpstat Site Audit — позволяет сравнивать sitemap с фактическими страницами в индексе.

- JetOctopus — глубокая проверка краулинга, индексации, файлов robots.txt и карты сайта.

Пошаговая инструкция:

- Добавьте свой домен в систему.

- Запустите полное сканирование (Site Audit).

- Просмотрите раздел Indexation/Crawlability.

- Экспортируйте отчет для дальнейшей обработки.

Преимущества

- Массовый анализ сотен тысяч страниц.

- Удобная интеграция с аналитикой и поисковыми данными.

- Визуализация проблем и динамики индексации.

Недостатки

- Частично данные основаны на сторонних источниках, не всегда 100% точные.

- Некоторые сервисы являются платными.

5. Проверка соответствия sitemap.xml и robots.txt

Корректная работа индексации напрямую зависит от правильных настроек sitemap.xml и robots.txt.

Проверка sitemap.xml:

- Откройте в браузере:

yourdomain.com/sitemap.xml - Убедитесь, что карта сайта содержит актуальные страницы.

- В Google Search Console откройте раздел «Sitemaps» и проверьте статус подачи.

- Убедитесь, что Google не сообщает об ошибках обработки.

Проверка robots.txt:

- Откройте:

yourdomain.com/robots.txt - Проверьте наличие директив:

User-agent: * Disallow: /admin/Убедитесь, что важные страницы не заблокированы.

Проверяйте, чтобы между robots.txt и meta-robots не было конфликтов (например, страница открыта в robots.txt, но имеет тег noindex).

Почему Google не индексирует сайт: причины и решение

Если ваш сайт не появляется в результатах поиска Google, это означает, что страницы не попали в индекс. Чаще всего проблема связана с техническими настройками или качеством контента.

1. Запрет в файле robots.txt

Поисковый бот не может сканировать сайт из-за директивы Disallow: /.

Решение:

- Откройте

https://вашдомен.com/robots.txt. - Убедитесь, что нужные страницы открыты для индексации.

User-agent: * Allow: / Disallow: /admin/ - Проверьте настройки в Google Search Console → Тест robots.txt.

2. Тег noindex на страницах

Страница помечена как не подлежащая индексации.

- Удалите тег:

<meta name="robots" content="noindex"> - Проверьте шаблоны CMS (WordPress, OpenCart и т. д.).

- Используйте Screaming Frog для обнаружения таких страниц.

3. Отсутствующие внутренние или внешние ссылки

Google не может найти страницу без ссылок.

- Добавьте ссылку на страницу в меню, категории или статьи.

- Создайте или обновите sitemap.xml.

- Подайте карту сайта в Google Search Console.

- Получите хотя бы несколько внешних ссылок.

4. Слабый или дублирующийся контент

Страницы с неуникальным или «тонким» контентом Google может игнорировать.

- Напишите уникальный, ценный текст (минимум 400–600 слов).

- Добавьте структуру: заголовки, подзаголовки, мета-описание.

- Для дубликатов используйте тег:

<link rel="canonical" href="основная-страница">

5. Медленная скорость или ошибки сервера

Бот не может полноценно просканировать страницы из-за 404, 500 или низкой скорости загрузки.

- Проверьте сайт через PageSpeed Insights или Screaming Frog.

- Исправьте ошибки, редиректы и серверные сбои.

- Используйте кэширование и CDN.

6. Контент загружается через JavaScript

Google не видит текст, если он генерируется после загрузки страницы.

- Убедитесь, что контент доступен в исходном HTML.

- Используйте Server-Side Rendering (SSR) или Dynamic Rendering.

- Проверьте страницу через Инспекцию URL в Search Console.

7. Ограниченный crawl budget

Google сканирует только часть страниц, остальные остаются вне индекса.

- Закройте неважные страницы (фильтры, поиск, теги) через

robots.txtилиnoindex. - Оптимизируйте структуру сайта.

- Улучшите скорость работы ресурса.

8. Новый сайт или домен без доверия

Google осторожно индексирует новые сайты, пока не убедится в их надежности.

- Добавьте сайт в Search Console.

- Подайте sitemap.xml.

- Публикуйте новый уникальный контент.

- Получите внешние ссылки с авторитетных сайтов.

- Для ускорения индексации используйте Google Indexing API.

Соблюдение этих простых рекомендаций поможет вашему сайту быстрее попасть в индекс и стабильно появляться в поиске Google.

FAQ

1. Сколько времени нужно для индексации?

От нескольких часов до нескольких дней. Скорость зависит от качества сайта, доверия домена и наличия sitemap.xml.

2. Почему страница не индексируется?

Может быть заблокирована в robots.txt, иметь тег noindex, дублированный или слабый контент.

3. Как ускорить индексацию?

Подайте sitemap.xml, добавьте внутренние ссылки, обновляйте контент, используйте Google Indexing API.

4. Что означает «Обнаружено — пока не индексировано»?

Google нашел страницу, но не считает ее достаточно ценной. Улучшите контент и добавьте ссылки.

5. Влияет ли на индексацию скорость сайта?

Да. Медленные сайты обходятся реже. Проверьте скорость через PageSpeed Insights.

6. Как удалить страницу из индекса?

Добавьте noindex или воспользуйтесь Инструментом удаления URL в Search Console.

7. Как предотвратить проблемы с индексацией?

Регулярно проверяйте Search Console, обновляйте sitemap.xml, избегайте дубликатов и улучшайте качество контента.

Читайте также: Как создать бизнес-страницу в Фейсбук